BERT相关——(5)Pre-train Model

Bert相关——(5)Pre-train Model

引言

过去NLP领域通常是一个任务一个模型,但今天已经逐渐迈向:模型先了解普遍的语言,再去解各式各样的NLP任务——pre-train+fine tuning范式。

根据大量无标注的文字资料来训练一个模型,希望这个模型能读懂文字,这个训练过程就叫Pre-train预训练。接下来针对不同的下游任务再收集少量对应的、有标注的训练资料去Fine-tune微调预训练的模型,然后就可以让机器去完成不同的下游任务。

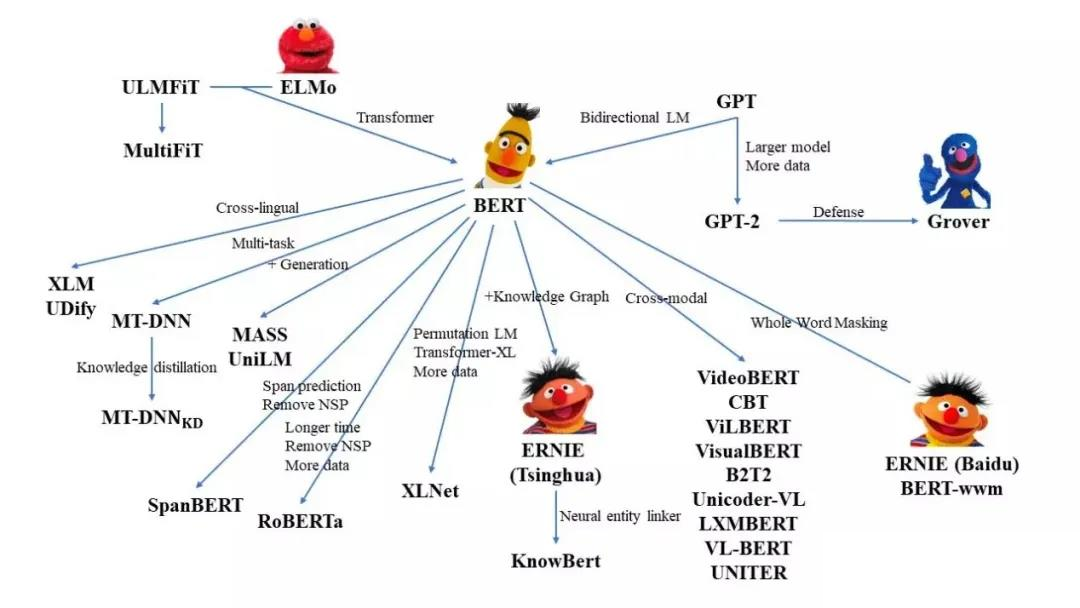

之前介绍了BERT的原理,BERT可以用于Pre-train+fine tuning范式。

这篇先介绍BERT的pre-train方法,并介绍如何利用HuggingFace(抱抱脸)的Transformers包进行BERT预训练。

Pre-train

Pre-train Model做的是”represent each token by a embedding vector“,这个vector应该包含了这个token的语义,意思相近的token应该有相似的embedding,且embedding的某些维度应该是代表某些特定的语义。

之前在BERT相关——(2)Contextualized Word Embedding和ELMO模型)中提到过,word2vec,Glove等,就是经典的获取word embedding的预训练模型。

BERT也是其中一种Pre-train model,可以用于学习Contextualized word embedding。

BERT for Pre-train

根据之前写的博客BERT相关——(3)BERT模型,我们用Transformers实现BERT模型进行预训练需要以下几个步骤:

- 利用Tokenizer对语料分词;

- 重新配置模型;

- 编写满足训练任务的处理代码:每个句子进行掩膜并组成句子对的正负样本集合以完成BERT训练的两个任务;

- 数据输入模型进行训练。

利用Tokenizer对语料分词

这里提供四种训练自己的Tokenizer的方法:

方法1:

来自官方最新文档(截至2021-08-22)

from tokenizers import Tokenizer |

方法2:

来自:HuggingFace官方:How to train a language model from scratch

%%time |

方法3:

来自:使用huggingface的Transformers预训练自己的bert模型+FineTuning稍作修改。

# 创建分词器

bwpt = tokenizers.BertWordPieceTokenizer()

filepath = "../excel2txt.txt" # 语料文件

#训练分词器

bwpt.train(

files=[filepath],

vocab_size=50000, # 这里预设定的词语大小不是很重要

min_frequency=1,

limit_alphabet=1000,

special_tokens=["[UNK]", "[CLS]", "[SEP]", "[PAD]", "[MASK]"]

)

# 保存训练后的模型词表

bwpt.save_model('./pretrained_models/')

#output: ['./pretrained_models/vocab.txt']

# 加载刚刚训练的tokenizer

tokenizer=BertTokenizer(vocab_file='./pretrained_models/vocab.txt')

如果已经有了词汇表,不需要去训练分词,可以直接用最后一句代码加载词汇表,得到对应的tokenizer,注意里面需要添加"[UNK]", "[CLS]", "[SEP]", "[PAD]", "[MASK]"等特殊词。

方法4:

来自使用huggingface的Transformers预训练自己的bert模型+FineTuning稍作修改。

from tokenizers.decoders import ByteLevel as ByteLevelDecoder

from tokenizers.models import BPE

from tokenizers.normalizers import Lowercase, NFKC, Sequence

from tokenizers.pre_tokenizers import ByteLeve

from tokenizers.trainers import BpeTrainer

# 1、创建一个空的字节对编码模型

tokenizer = Tokenizer(BPE())

#2、启用小写和unicode规范化,序列规范化器Sequence可以组合多个规范化器,并按顺序执行

tokenizer.normalizer = Sequence([

NFKC(),

Lowercase()

])

#3、标记化器需要一个预标记化器,负责将输入转换为ByteLevel表示。

tokenizer.pre_tokenizer = ByteLevel()

# 4、添加解码器,将token令牌化的输入恢复为原始的输入

tokenizer.decoder = ByteLevelDecoder()

# 5、初始化训练器,给他关于我们想要生成的词汇表的详细信息

trainer = BpeTrainer(vocab_size=858, show_progress=True, initial_alphabet=ByteLevel.alphabet())

# 6、开始训练我们的语料

tokenizer.train(files=["./tmp/all_data_txt.txt"], trainer=trainer,special_tokens=["[UNK]", "[CLS]", "[SEP]", "[PAD]", "[MASK]"])

# 最终得到该语料的Tokenizer,查看下词汇大小

print("Trained vocab size: {}".format(tokenizer.get_vocab_size()))

# 保存训练的tokenizer

tokenizer.save('./my_token/')上述的训练过程其实是针对的是byte级别的BPE编码,tokenizer保存为两个文件,分别是

vocab.json,merges.txt。merges.txt文件在Robert中会用到,,普通的bert只需要vocab。这两个文件,可以用官方封装好的Tokenizer直接加载,如下:

from tokenizers.processors import BertProcessing

tokenizer = ByteLevelBPETokenizer(

"vocab.json",

"merges.txt",

)

让我们用官方的小例子来试验一下:

output = tokenizer.encode("Hello, y'all! How are you 😁 ?") |

重新配置模型

from transformers import ( |

编写满足训练任务的处理代码

Next Sentence Prediction(NSP)任务

我们可以对输入进行预处理,比如在BERT中就需要构建句子对用于Next Sentence Prediction(NSP)任务。

from tokenizers.processors import TemplateProcessing |

Masked Language Model(MLM)任务

Masked Language Model(MLM)任务在DataCollatorForLanguageModeling中进行设置。

from transformers import PreTrainedTokenizerFast |

训练

加载数据集

我们用LineByLineTextDataset加载数据集。

%%time |

开始训练

from transformers import Trainer, TrainingArguments |

快速检查模型是否训练

除了查看训练和评估损失下降之外,检查我们的语言模型是否正在学习任何有趣的东西的最简单方法是通过 FillMaskPipeline。

语法检查

语法检查,用于查看mask的位置是否能输出一个正确词性的单词:

from transformers import pipeline |

参考文献

课程向:深度学习与人类语言处理 ——李宏毅,2020 (P19)