西瓜书阅读笔记——第3章-对数几率回归(3.3)

西瓜书阅读笔记——第3章-对数几率回归(3.3)

强烈推荐配合西瓜书阅读使用的南瓜书和南瓜书作者录制的学习视频【吃瓜教程】《机器学习公式详解》(南瓜书)与西瓜书公式推导直播合集。

线性分类模型

单调阶跃函数(unit-step function) Heaviside函数

不连续、不可微,若预测值大于零就判为正例,小于零则判为反例,预测值为临界值则可任意判别。

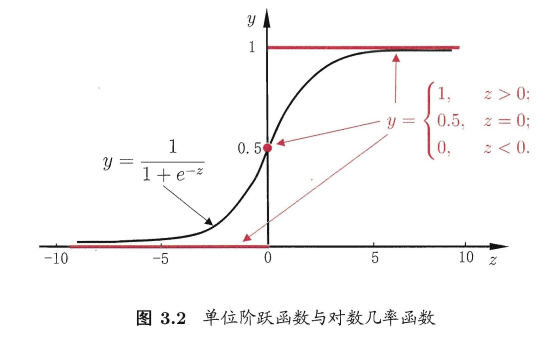

sigmoid函数——对数几率函数(logistic function)

sigmoid函数是形似S的函数。

对数几率函数是sigmoid函数的一种,单调可微,其表达式为: \[ y=\frac{1}{1+e^{-z}} \] 与单调阶跃函数的图示关系如下图所示:

几率和对数几率

若将\(y\)视为样本作为正例的可能性,则\(1-y\)是其反例可能性,两者的比值\(\frac{y}{1-y}\)称为几率(odds),反映了\(\mathbf x\)作为正例的相对可能性.对几率取对数则得到"对数几率"(log odds,亦称logit):\(\ln\frac{y}{1-y}\)

对数几率回归模型(线性分类模型)

模型

原理

线性分类模型是在线性模型的基础上套一个映射函数来实现分类功能。即,将\(z=\mathbf w^T\mathbf x+b\)带入对数几率函数中,得到: \[ y=\frac{1}{1+e^{-(\mathbf w^T\mathbf x+b)}} \] 其对应的模型称为"对数几率回归"(logistic regression,亦称logit regression)(虽叫回归但实际是分类方法)。

带入\(\ln\frac{y}{1-y}\)中可得:\(\ln\frac{y}{1-y}={\mathbf w^T}\mathbf x+b\),即,利用线性回归模型的预测结果去逼近真实标记的对数几率。

对数几率回归模型对应到机器学习三要素中分别为:

- 模型:线性模型,输出值范围为[0,1],近似阶跃的单调可微函数\(y=\frac{1}{1+e^{-(\mathbf w^T\mathbf x+b)}}\)。

- 策略:极大似然估计,信息论。

- 算法:梯度下降法,牛顿法。

优势

- 直接对分类可能性进行建模,无需事先假设数据分布,避免了假设分布不准确所带来的问题;

- 不是仅预测出"类别",而是可得到近似概率预测,这对许多需利用概率辅助决策的任务很有用;

- 对率函数是任意阶可导的凸函数,现有的许多数值优化算法都可直接用于求取最优解。

策略——构建loss function

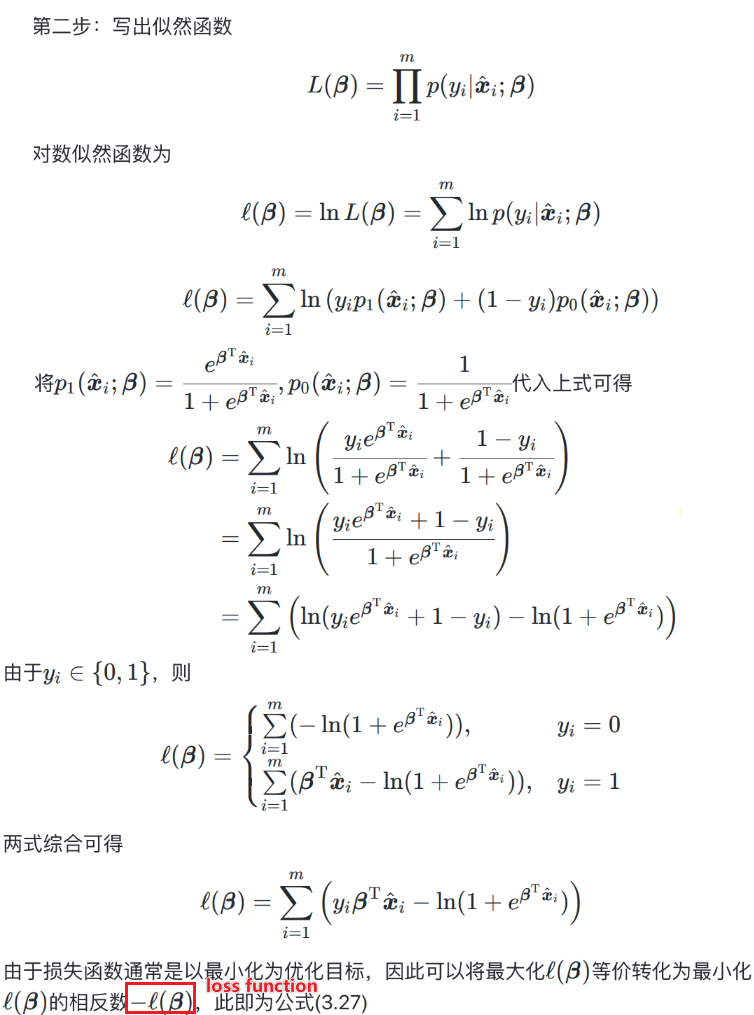

极大似然估计

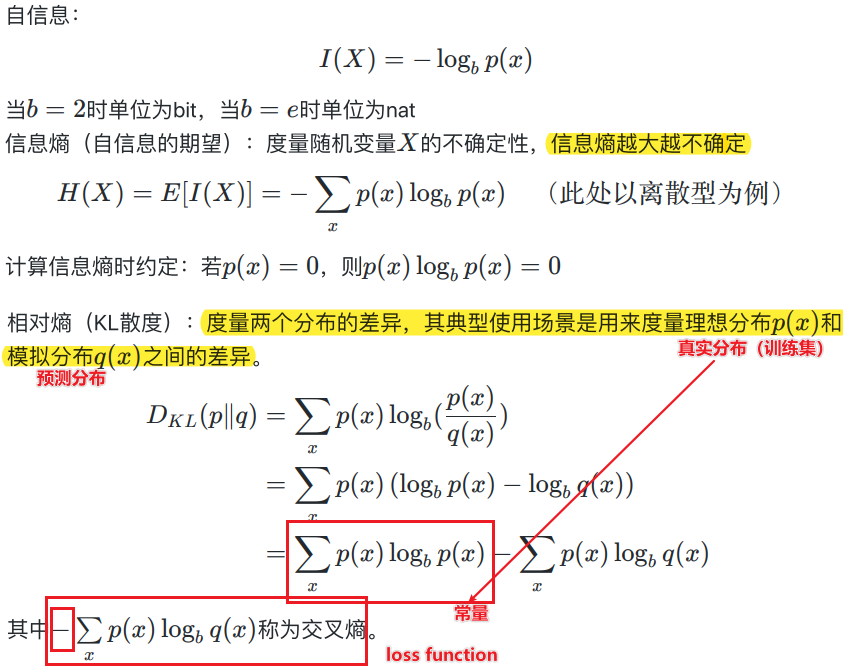

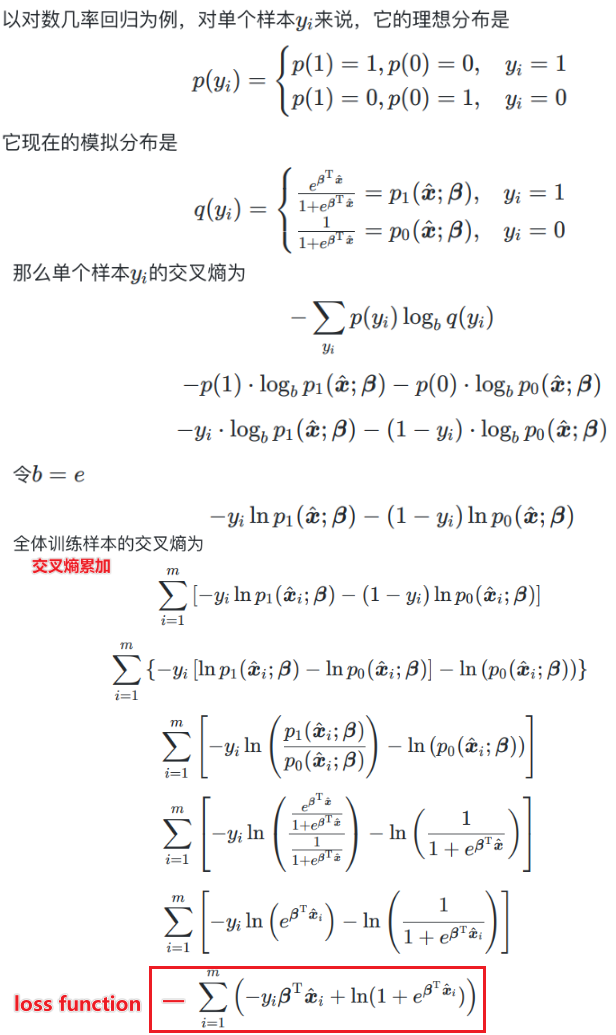

信息论

算法——求解参数

上面推导的loss function是关于\(β\)的高阶可导连续凸函数,根据凸优化理论,经典的数值优化算法如梯度下降法(gradient descent method)、牛顿法(Newton method)等都可求得其最优解。 \[ β^*=\mathop{argmin}\limits_β\ell(β) \]

参考文献

【吃瓜教程】《机器学习公式详解》(南瓜书)与西瓜书公式推导直播合集

*视频的PPT:https://pan.baidu.com/s/1g1IrzdMHqu6XyG0bFIcFsA 提取码: 7nmd