Pytorch与深度学习自查手册3-模型定义

Pytorch与深度学习自查手册3-模型定义

定义神经网络

- 继承

nn.Module类; - 初始化函数

__init__:网络层设计; forward函数:模型运行逻辑。

class NeuralNetwork(nn.Module): |

权重初始化

方法1:net.apply(weights_init)

def weights_init(m): |

方法2:在网络初始化的时候进行参数初始化

- 使用net.modules()遍历模型中的网络层的类型;

- 对其中的m层的weigth.data(tensor)部分进行初始化操作。

class Model(nn.Module): |

常用的操作

利用nn.Parameter()设计新的层

import torch |

nn.Flatten

展平输入的张量: 28x28 -> 784

input = torch.randn(32, 1, 5, 5) |

nn.Sequential

一个有序的容器,神经网络模块将按照在传入构造器的顺序依次被添加到计算图中执行,同时以神经网络模块为元素的有序字典也可以作为传入参数。

net = nn.Sequential( |

常用的层

全连接层nn.Linear()

torch.nn.Linear(in_features, out_features, bias=True,device=None, dtype=None)

in_features: 输入维度 |

m = nn.Linear(20, 30) |

torch.nn.Dropout

''' |

卷积torch.nn.ConvNd()

class torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True)

in_channels(int) – 输入信号的通道 |

input: (N,C_in,H_in,W_in) N为批次,C_in即为in_channels,即一批内输入二维数据个数,H_in是二维数据行数,W_in是二维数据的列数 output: (N,C_out,H_out,W_out) N为批次,C_out即为out_channels,即一批内输出二维数据个数,H_out是二维数据行数,W_out是二维数据的列数

conv2 = nn.Conv2d( |

池化

最大池化torch.nn.MaxPoolNd()

torch.nn.MaxPool2d(kernel_size, stride=None, padding=0, dilation=1, return_indices=False, ceil_mode=False)

kernel_size- 窗口大小 |

max2=torch.nn.MaxPool2d(3,1,0,1) |

均值池化torch.nn.AvgPoolNd()

kernel_size - 池化窗口大小 |

torch.nn.AvgPool2d(kernel_size, stride=None, padding=0, ceil_mode=False, count_include_pad=True) |

反池化

是池化的一个“逆”过程,但“逆”只是通过上采样恢复到原来的尺寸,像素值是不能恢复成原来一模一样,因为像最大池化是不可逆的,除最大值之外的像素都已经丢弃了。

最大值反池化nn.MaxUnpool2d()

功能:对二维图像进行最大值池化上采样

参数:

kernel_size- 窗口大小 |

torch.nn.MaxUnpool2d(kernel_size, stride=None, padding=0) |

img_tensor=torch.Tensor(16,5,32,32) |

组合池化

组合池化同时利用最大值池化与均值池化两种的优势而引申的一种池化策略。常见组合策略有两种:Cat与Add。其代码描述如下:

def add_avgmax_pool2d(x, output_size=1): |

正则化层

Transformer相关——(6)Normalization方式

BatchNorm

torch.nn.BatchNorm1d(num_features, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True) |

参数:

num_features: 来自期望输入的特征数,该期望输入的大小为batch_size × num_features [× width],和之前输入卷积层的channel位的维度数目相同 |

# With Learnable Parameters |

LayerNorm

torch.nn.LayerNorm(normalized_shape, eps=1e-05, elementwise_affine=True) |

参数:

normalized_shape: 输入尺寸 |

LayerNorm就是对(2, 2,4), 后面这一部分进行整个的标准化。可以理解为对整个图像进行标准化。

x_test = np.array([[[1,2,-1,1],[3,4,-2,2]], |

InstanceNorm

torch.nn.InstanceNorm1d(num_features, eps=1e-05, momentum=0.1, affine=False, track_running_stats=False) |

参数:

num_features: 来自期望输入的特征数,该期望输入的大小为batch_size x num_features [x width] |

InstanceNorm就是对(2, 2, 4)最后这一部分进行Norm。

x_test = np.array([[[1,2,-1,1],[3,4,-2,2]], |

GroupNorm

torch.nn.GroupNorm(num_groups, num_channels, eps=1e-05, affine=True) |

参数:

num_groups:需要划分为的groups |

当GroupNorm中group的数量是1的时候, 是与上面的LayerNorm是等价的。

x_test = np.array([[[1,2,-1,1],[3,4,-2,2]], |

当GroupNorm中num_groups的数量等于num_channel的数量,与InstanceNorm等价。

# Separate 2 channels into 2 groups (equivalent with InstanceNorm) |

激活函数

参考资料:GELU 激活函数

torch.nn.GELU

\[ GELU(x)=xP(X<=x)=xΦ(x) \]

这里$Φ ( x ) \(是正太分布的概率函数,可以简单采用正太分布\)N ( 0 , 1 )\(要,或者使用参数化的正太分布\)N ( μ , σ )$ ,然后通过训练得到\(μ\)。

对于假设为标准正太分布的\(GELU(x)\),论文中提供了近似计算的数学公式,如下: \[ GELU(x) = 0.5x(1+tanh[\sqrt{2/\pi}(x+0.044715x^3)]) \] bert源码给出的GELU代码pytorch版本表示如下:

def gelu(input_tensor): |

\[ erf(x)= \frac{2}{π}∫_0^xe^{−t^2}dt \]

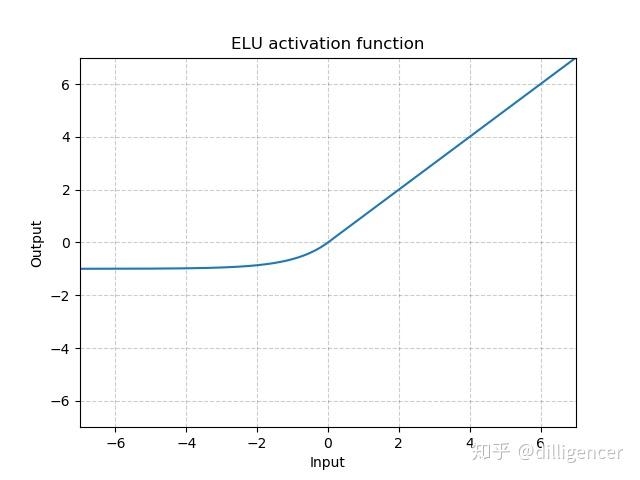

torch.nn.ELU(alpha=1.0,inplace=False)

def elu(x,alpha=1.0,inplace=False): |

α是超参数,默认为1.0

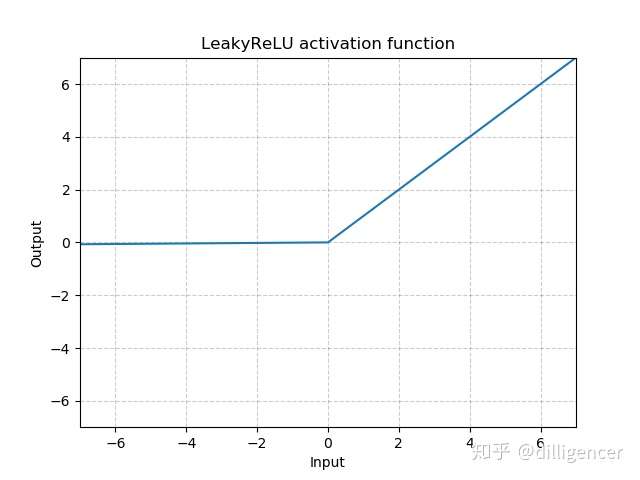

torch.nn.LeakyReLU(negative_slope=0.01,inplace=False)

def LeakyReLU(x,negative_slope=0.01,inplace=False): |

其中 negative_slope是超参数,控制x为负数时斜率的角度,默认为1e-2

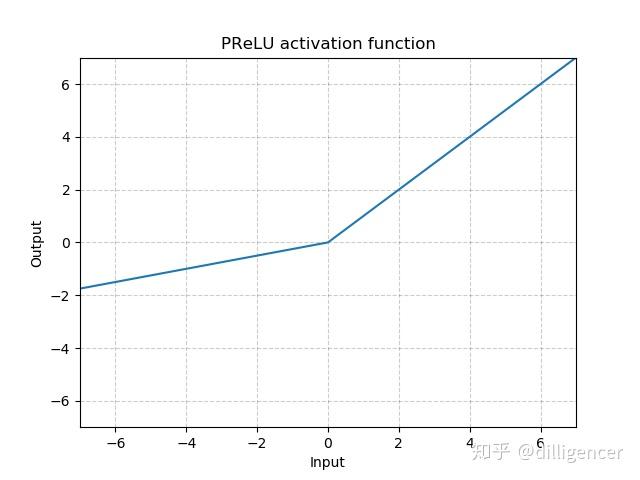

torch.nn.PReLU(num_parameters=1,init=0.25)

def PReLU(x,num_parameters=1,init=0.25): |

其中a 是一个可学习的参数,当不带参数调用时,即nn.PReLU(),在所有的输入通道上使用同一个a,当带参数调用时,即nn.PReLU(nChannels),在每一个通道上学习一个单独的a。

注意:当为了获得好的performance学习一个a时,不要使用weight decay。

num_parameters:要学习的a的个数,默认1

init:a的初始值,默认0.25

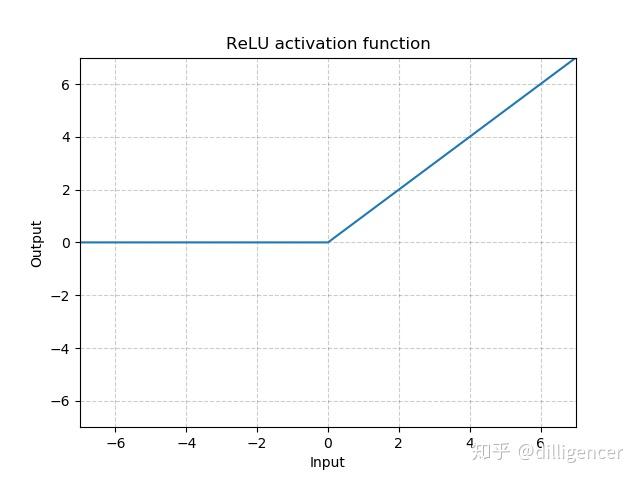

torch.nn.ReLU(inplace=False)

CNN中最常用ReLu。

def ReLU(x,inplace=False): |

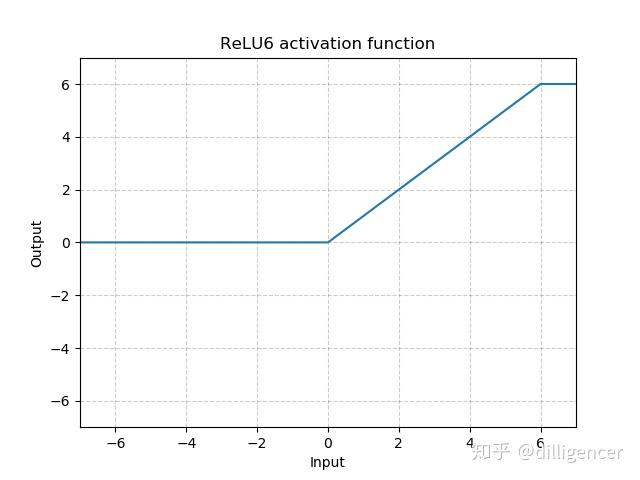

torch.nn.ReLU6(inplace=False)

def ReLU6(x,inplace=False): |

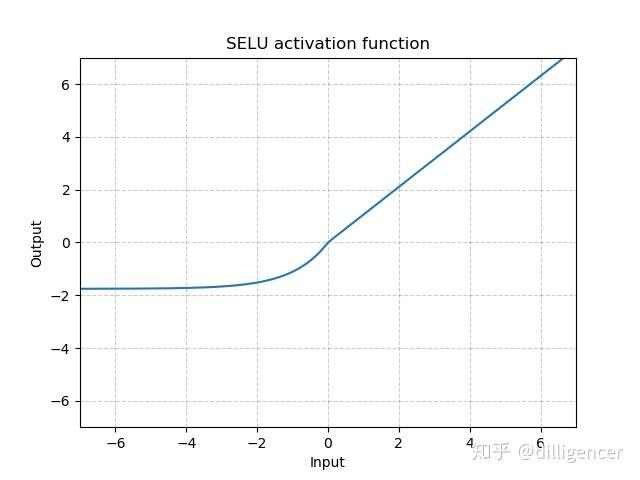

torch.nn.SELU(inplace=False)

def SELU(x,inplace=False): |

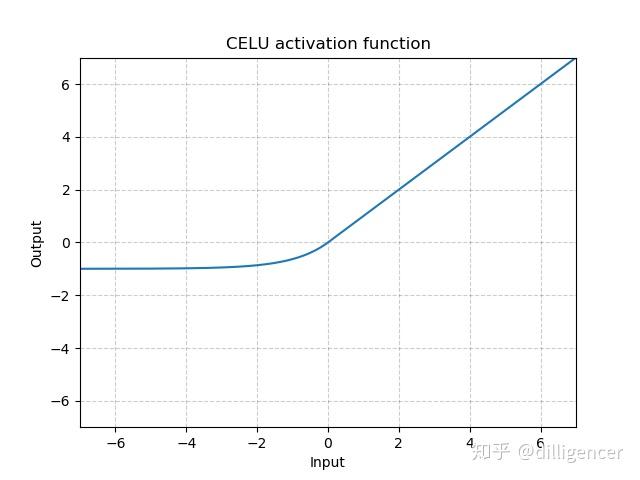

torch.nn.CELU(alpha=1.0,inplace=False)

def CELU(x,alpha=1.0,inplace=False): |

其中α 默认为1.0

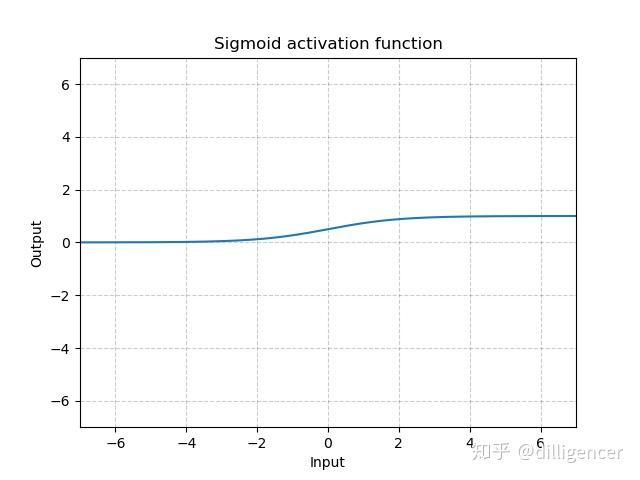

torch.nn.Sigmoid

\[ Sigmoid(x)=\frac{1}{1+exp(-x)} \]

def Sigmoid(x): |

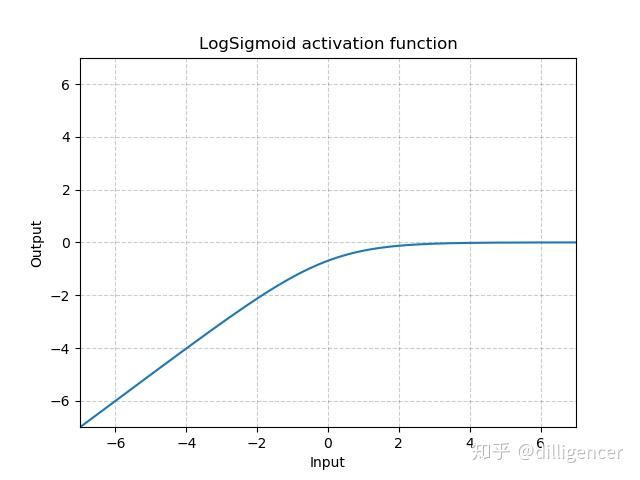

torch.nn.LogSigmoid

\[ LogSigmoid(x)=log(\frac{1}{1+exp(-x)}) \]

def LogSigmoid(x): |

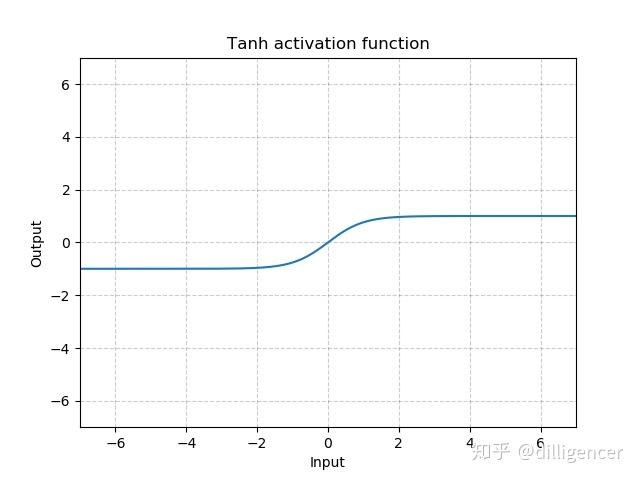

torch.nn.Tanh

\[ Tanh(x)=tanh(x)=\frac{e^{x}-e^{-x}}{e^{x}+e^{-x}} \]

def Tanh(x): |

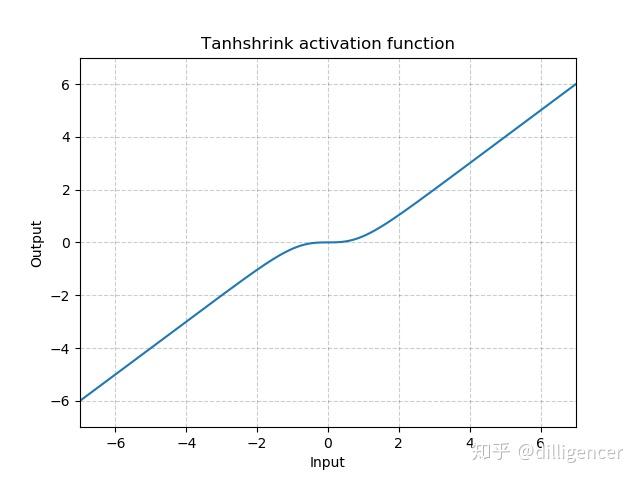

torch.nn.Tanhshrink

\[ Tanhshrink(x)=x−Tanh(x) \]

def Tanhshrink(x): |

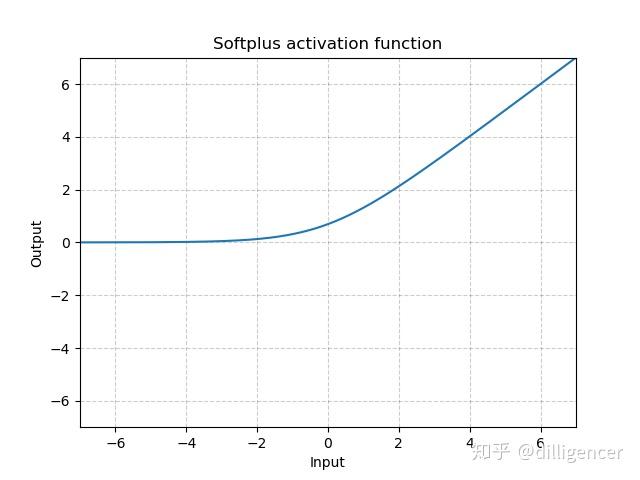

torch.nn.Softplus(beta=1,threshold=20)

\[ Softplus(x)=\frac{1}{\beta}*log(1+exp(\beta*x)) \]

该函数可以看作是ReLu的平滑近似。

def Softplus(x,beta=1,threshold=20): |

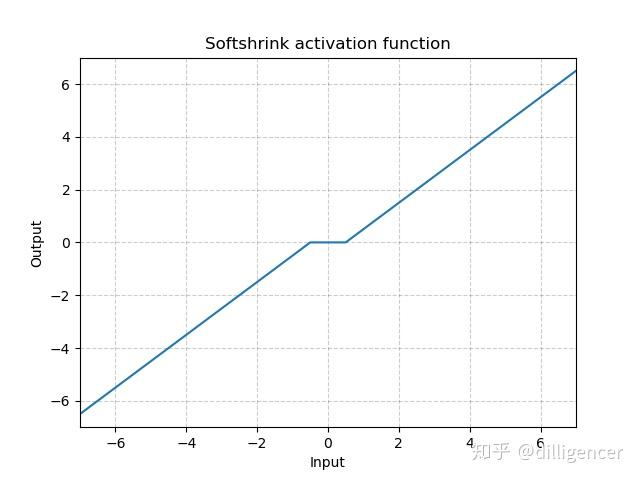

torch.nn.Softshrink(lambd=0.5)

\[ SoftShrinkage(x) = \left\{ \begin{array}{ll} x-\lambda, & \textrm{if $x>\lambda$}\\ x+\lambda, & \textrm{if $x<-\lambda$}\\ 0, & \textrm{otherwise} \end{array} \right. \]

λ的值默认设置为0.5

def Softshrink(x,lambd=0.5): |

nn.Softmax

\[ Softmax(x_i)=\frac{exp(x_i)}{∑_jexp(x_j)} \]

m = nn.Softmax(dim=1) |